Les conversations privées des utilisateurs avec ChatGPT sont cryptées. Et malgré cela, les hackers les lisent

ChatGPT fait désormais partie de la vie de millions de personnes qui l'utilisent quotidiennement pour différentes tâches allant de la préparation des entretiens d'embauche à la synthèse des réunions. Mais, Dans quelle mesure vos conversations sont-elles exposées ? Nous savons depuis un certain temps qu'OpenAI peut utiliser le contenu du chat pour améliorer ses modèles d'IA, à moins que l'historique des chats ne soit désactivé ou que la version payante de ChatGPT Enterprise ne soit utilisée.

Ce qui précède signifie que certains employés de l'entreprise dirigée par Sam Altman ont la possibilité d'accéder à vos conversations à des fins techniques ou de sécurité. C’est pourquoi il est si important de ne pas partager d’informations confidentielles, mais plutôt de dire à Samsung qu’il a fini par interdire l’utilisation de ChatGPT à ses employés. Au-delà de cela, il existe d’autres façons dont les conversations peuvent se retrouver entre les mains d’un tiers, par exemple un cybercriminel.

La cyberattaque qui compromet la sécurité de ChatGPT

Imaginez que vous êtes dans un café en utilisant ChatGPT depuis votre ordinateur portable connecté au réseau Wi-Fi public. Ce scénario pourrait être propice à ce qu'un attaquant utilise certains éléments à sa portée pour essayez de déduire les réponses du chatbot. Tout cela, sans que vous vous en rendiez compte. Les informations sur l'attaque que nous expliquerons ci-dessous proviennent d'une étude intéressante du Laboratoire de recherche offensive sur l'IA de l'Université Ben Gourion en Israël, qui se déroule essentiellement en quatre étapes :

- Intercepter le trafic de la victime

- Filtrer les paquets pour trouver les réponses ChatGPT

- Révéler la longueur du jeton

- Déduire la réponse ChatGPT à l'aide d'un LLM

Si vous êtes utilisateur de ChatGPT, vous aurez sûrement remarqué que le chatbot vous envoie progressivement la réponse. On peut également expliquer ce processus de la manière suivante : le modèle, GPT-3.5 ou GPT-4, transmet les tokens à votre ordinateur car il les génère. Désormais, bien que cette transmission séquentielle soit cryptée, elle ouvre la porte à l’utilisation d’un type d’attaque dit capable de révéler la longueur des jetons pour en déduire des informations.

Le défi de l'attaquant à ce stade est d'intercepter les données envoyées entre les serveurs OpenAI et votre ordinateur, ce qui peut être réalisé avec une attaque du type . Une fois que l'acteur malveillant a compromis la sécurité du réseau, il filtrera le trafic par adresse IP et analysera les paquets pour un modèle incrémentiel afin de découvrir les paquets liés aux réponses ChatGPT.

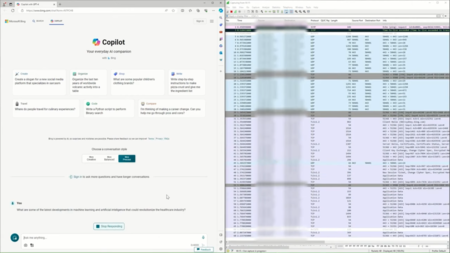

Cette capture d'écran partagée par les chercheurs montre comment les paquets de la victime sont interceptés

Vous pouvez ensuite identifier la longueur des jetons à l'aide des tailles de paquets observées précédemment. C'est précisément ici que se situe le plus grand niveau de difficulté : étant donné qu'un jeton peut représenter une unité de texte aussi courte qu'un caractère ou aussi longue qu'un ensemble de mots, il faut recourir à une solution supplémentaire pour les interpréter et en déduire les réponses. La solution des chercheurs a été d'utiliser un LLM pour cette tâche.

Nous parlons d'un modèle de langage long spécialement formé, capable d'analyser la longueur des jetons et de prédire avec assez de précision les réponses générées par ChatGPT. Les résultats peuvent varier, mais lors des tests, le modèle a pu déduire 55 % de toutes les réponses avec une grande précision (les mots peuvent légèrement changer, mais le sens de la phrase légèrement). De plus, 29 % d’entre eux avaient une précision parfaite.

Bien qu’il s’agisse d’une attaque qui nécessite certains éléments sophistiqués pour être exécutée, il n’est jamais inutile de garder à l’esprit la mesure dans laquelle nos données peuvent finir par être exposées. A noter que cette technique, selon les chercheurs, fonctionne non seulement avec ChatGPT, mais aussi avec d'autres robots d'intelligence artificielle comme Copilot qui envoie les jetons de manière séquentielle. Le Gemini de Google n'est pas atteint, précisément parce qu'il a une architecture différente.

Images | Levart_Photographe | Viralyft

À Simseo | 600 personnes ont été secourues aux Philippines. Ils avaient été kidnappés et forcés de travailler comme amoureux en ligne dans des escroqueries