Le prix à payer pour avoir l’IA est le pillage de tous les contenus Internet. Et Perplexity n'est que le dernier exemple

Midjourney et ChatGPT ils ont l'air magiques. Ils créent des œuvres et des textes numériques de manière étonnante, et même s’ils se trompent souvent, leurs résultats sont souvent convaincants, voire impressionnants. Cette photo du pape dans un manteau Balenciaga semble toujours réelle et ce code Python fonctionne. J'insiste. Ils semblent magiques.

Mais ces modèles d’IA générative et leurs concurrents ne sont pas magiques. Ce sont des perroquets stochastiques qui utilisent des modèles statistiques. Ils ne comprennent pas ce qu’ils créent ou génèrent. Et puis, tout ce qu’ils font repose sur quelque chose d’encore plus important.

Voler.

Si c'est sur Internet, je peux l'utiliser pour mon IA

C'est ce qu'ils font depuis le début. Les grandes entreprises d’IA ont besoin d’énormes quantités de données pour entraîner leurs modèles. Ce qu'ils ont fait, c'est simplement les prendre sur Internet. Sans avertissement, sans demander la permission et sans clarifier ultérieurement quelles données ils avaient utilisées.

Aucune entreprise d’IA ne précise comment elle a formé ces modèles. Nous ne savons pas exactement d'où ils ont obtenu toutes les informations. Quels livres, sites Web ou images avez-vous inclus dans la formation ? La transparence est pratiquement nulle.

Aucun d’entre eux ne le clarifie complètement et toutes les entreprises se cachent derrière le concept de « usage équitable » (utilisation équitable). Ce concept développé en common law permet une utilisation limitée du matériel protégé sans nécessiter d'autorisation pour le faire.

Cette collecte massive et vorace de données a causé des problèmes juridiques à de nombreuses entreprises d’IA. Les poursuites pour d’éventuelles violations de la propriété intellectuelle ont commencé à arriver très tôt et sont devenues de plus en plus fréquentes.

Qu’ont commencé à faire les entreprises d’IA face à ces poursuites (ou à la menace qu’elles finissent par les affecter) ? Conclure des accords avec certains fournisseurs de contenu.

Avant, certains prenaient tout ce qu'ils pouvaient sur des plateformes comme Reddit, mais maintenant, Google et OpenAI ont résolu leurs différends après avoir négocié différents types de contrepartie.

Et ce qui s'est passé avec Reddit s'est produit avec des groupes d'édition comme Prisa ou Le Monde, et cela continuera à se produire dans le futur : ainsi les majors de l'IA se protègent et peuvent continuer à alimenter leurs modèles sans s'arrêter.

La perplexité et les pailles qui remplissent le dos du chameau

Mais il existe des comportements encore plus contradictoires. Nous en avons un parfait exemple avec Perplexity, qui est petit à petit devenu une formidable alternative à Google et même à Wikipédia.

Ici, nous ne nous trouvons pas avec un moteur de recherche, mais, comme le souligne The Verge, avec un « moteur de réponse ». Le problème est de savoir comment il a réussi à faire ce qu’il fait.

Ce n'est pas ni plus ni moins que voler.

Elle l’a fait encore plus que certains de ses concurrents, car cette startup fait des choses sans précédent. Tout d’abord, il plagie des articles entiers provenant d’autres médias. Il l'a fait avec une chanson de Wired, par exemple.

Deuxièmement, il contourne les paywalls de publications comme Forbes afin de collecter des informations liées à certains sujets. Non seulement il a dépassé ce mur payant, mais il a à peine cité les recherches originales de Forbes et a plagié les graphiques et les images de ce sujet.

La découverte a généré une nouvelle controverse dans ce domaine. Wired a directement accusé Perplexity d'être une machine à faire de la merde, mais la société a tenté de s'écarter en indiquant qu'elle débattait de la manière de partager les revenus avec les publications.

Cette société d'intelligence artificielle Elle n'est pas la seule à sauter par-dessus ces murs: Ces jours-ci, il a été révélé que Poe, le chatbot de la plateforme de questions et réponses Quora, l'avait également fait. Alors que certains experts affirment qu'il s'agit d'une violation flagrante des droits d'auteur de ce contenu, Quora affirme que ce n'est pas le cas et qu'ils s'appuient sur des services de « lecture ultérieure » conformes à la loi.

Et puis vint la troisième et dernière découverte faite par un développeur nommé Robb Knight. Comme il l'a expliqué sur son blog, chez Perplexity, ils étaient ignorer les directives du fichier robots.txt qui indiquent précisément aux robots d'exploration Internet quelles pages explorer et lesquelles ne pas explorer.

Ces petits fichiers ont toujours servi à empêcher, par exemple, que Google affiche certaines parties d'un site Web dans ses résultats, mais les gars de Perplexity s'en fichaient : ils collectaient absolument tout.

Srinivas a fait valoir un point : ce ne sont pas eux qui l'ont ignoré, mais les entreprises qu'ils avaient embauchées pour explorer le Web et fournir de plus en plus de données pour leur modèle d'IA. Et bien sûr, Perplexity n’est pas le seul à éviter et ignorer les fichiers robots.txt : OpenAI et Anthropic font exactement la même chose.

Cette attitude a poussé Reddit, par exemple, à se lancer sur le sentier de la guerre contre les scrapers, même si cela durait depuis longtemps. Le New York Times, par exemple, a poursuivi Microsoft et OpenAI parce qu'il ne veut pas qu'un chatbot tue le journalisme. Ce journal a déjà publié un rapport en avril 2024 mettant en garde contre la façon dont la voracité d'entreprises comme OpenAI, Google ou Meta allait (soi-disant) exagérer lorsqu'il s'agissait de former leurs modèles.

Mais cela ne s'arrête pas là.

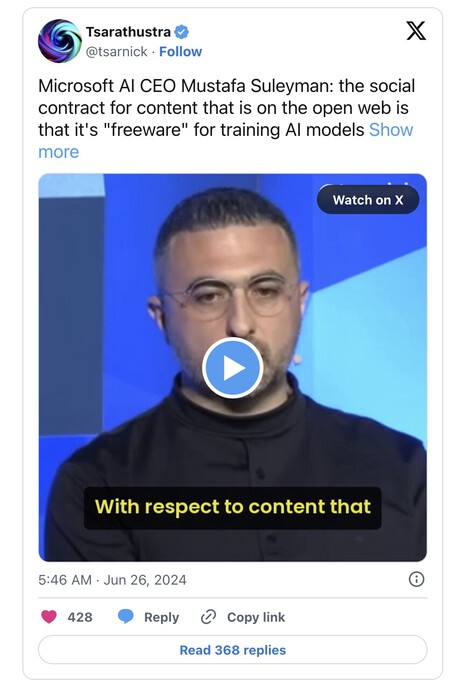

Cela a été démontré par le responsable de l'IA de Microsoft, Mustafa Suleyman, qui, dans une récente interview avec CNBC défendu cette collecte aveugle de données sur internet :

« Je pense qu'en ce qui concerne le contenu déjà présent sur le Web ouvert, le contrat social de ce contenu depuis les années 90 est qu'il s'agit d'un usage loyal. N'importe qui peut le copier, le recréer, le reproduire. C'est un logiciel gratuit, oui, c'est adoré, tel a été l'accord. »

Cette déclaration est terrible, surtout parce qu’elle suppose exactement ce que supposent toutes les grandes sociétés Internet. Ce qui signifie ni plus ni moins que tout ce que nous publions sur Internet est là pour qu’ils puissent en faire ce qu’ils veulent.

C’est précisément ce qu’ils font.

Images | Simseo avec Freepik

À Simseo | Les pannes ne sont pas ce qui arrête l'IA de Google : elle consomme autant d'électricité en une seconde que charger sept voitures électriques