De nouveaux travaux explorent les circonstances optimales pour atteindre un objectif commun avec les robots humanoïdes

Des chercheurs de l'Istituto Italiano di Tecnologia (IIT) ont démontré que dans certaines conditions, les humains peuvent traiter les robots comme les coauteurs des résultats de leurs actions. La condition pour que ce phénomène soit possible est que le robot se comporte de manière sociale, comme l'humain. La clé est d'établir un contact visuel et de participer à une expérience émotionnelle commune, comme regarder un film.

L'étude a été publiée dans Robotique scientifique et ouvre la voie à la compréhension et à la conception des circonstances optimales permettant aux humains et aux robots de collaborer dans le même environnement.

L'étude de recherche a été coordonnée par Agnieszka Wykowska, responsable du laboratoire de cognition sociale dans l'interaction homme-robot de l'IIT à Gênes, et chercheuse sur un projet intitulé « Position intentionnelle pour l'harmonisation sociale », qui aborde la question de savoir quand et dans quelles conditions les gens traiter les robots comme des agents intentionnels.

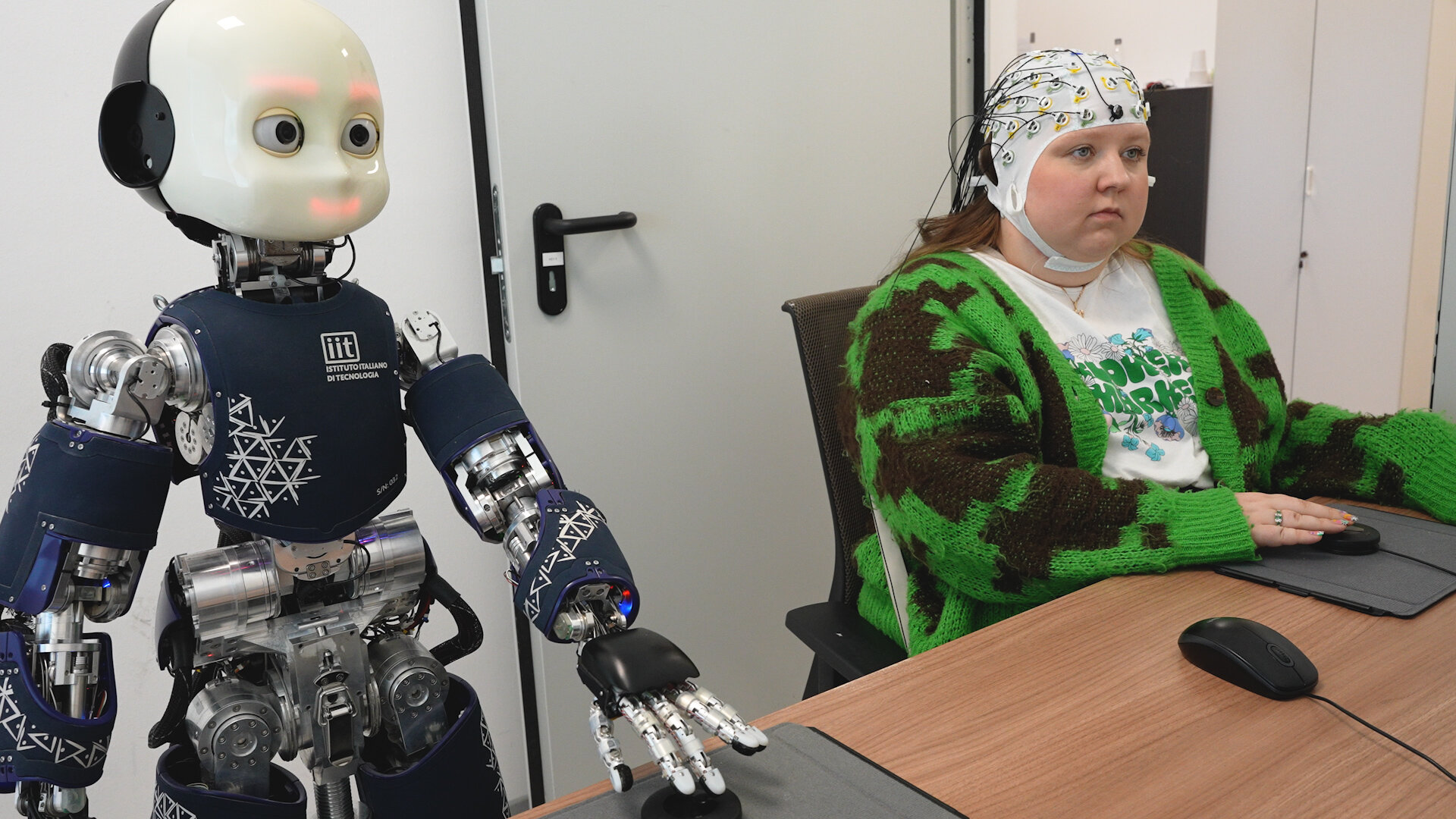

Uma Navare, première auteure de l'article et membre de l'équipe de Wykowska, a dirigé l'étude en utilisant des mesures comportementales et des réponses neuronales enregistrées par électroencéphalographie (EEG), pour évaluer l'émergence d'un mécanisme de contrôle partagé entre les humains et le robot humanoïde iCub.

« En tant qu'êtres humains, nous n'agissons pas dans un vide social et la plupart de nos actions nécessitent une coordination avec les autres dans l'espace et dans le temps pour atteindre un objectif. Un aspect crucial de l'interaction avec les autres est l'expérience de ce qu'on appelle le sentiment d'action conjointe, » explique Agnieszka Wykowska. « Dans notre étude, nous avons découvert que les humains éprouvaient ce sentiment d'action conjointe avec le robot partenaire lorsqu'il était présenté comme un agent intentionnel, mais pas lorsqu'il était présenté comme un artefact mécanique. »

Le sens de l'action conjointe fait référence au sentiment de contrôle que les humains éprouvent sur leurs propres actions et sur celles de leurs partenaires, ce qui sous-tend la cohésion d'équipe. Les chercheurs de l'IIT l'ont étudié en identifiant d'abord ses mécanismes dans les interactions entre humains, puis en testant si des réponses similaires se produiraient dans l'interaction homme-robot. La tâche d'interaction consistait à déplacer un curseur à l'écran vers un emplacement cible, puis à confirmer la position du curseur sur la cible, déclenchant ainsi un signal sonore.

Dans deux expériences, les chercheurs ont manipulé l’attribution de l’intentionnalité, c’est-à-dire de la ressemblance humaine, au robot iCub. Dans la première expérience, iCub effectuait une tâche de manière mécanique, ce qui amenait les participants à la considérer comme un artefact mécanique. Dans la deuxième expérience, les participants ont d’abord interagi avec iCub d’une manière qui augmentait la probabilité de lui attribuer une intentionnalité. Cela impliquait un dialogue, un échange de regards et le visionnage de vidéos ensemble, où iCub affichait des réponses émotionnelles semblables à celles des humains. Cela visait à faire en sorte que les participants perçoivent iCub comme plus intentionnel et plus humain.

Les chercheurs ont découvert que ce n’est que dans la deuxième expérience que les humains ressentaient conjointement un sentiment d’action avec le robot humanoïde, mis en évidence par des réponses comportementales et neuronales.

Ce résultat montre qu’un bon travail d’équipe avec un robot est plus susceptible de se produire lorsque le robot est perçu comme un agent intentionnel et social, mais pas lorsqu’il est considéré comme un dispositif mécanique. Il indique quelles sont les circonstances optimales pour que les humains et les robots collaborent vers des objectifs communs dans la vie quotidienne.