Google AI conseille d'utiliser de la colle pour le fromage à pizza. La source est un commentaire Reddit d'il y a 11 ans

Dans le monde de la pizza, le grand débat « avec ananas / sans ananas » est passé au second plan après la dernière bourde de Google. Ses modèles d’IA générative lui ont déjà causé des ennuis dans le passé, mais ils démontrent une fois de plus que (comme dans d’autres cas) il ne faut pas trop leur faire confiance.

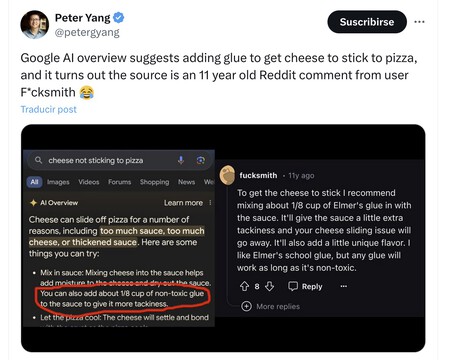

Colle pour fromage à pizza. Hier, un utilisateur a partagé une recherche sur Google. « Le fromage ne colle pas à la pizza », s'est-il plaint. Le nouveau moteur de recherche a déjà des résultats suggérés par l'IA, ce que Google appelle « AI Overview », et dans cette réponse, l'IA de Google a suggéré que « vous pouvez également ajouter 1/8 tasse de colle non toxique à la sauce pour lui donner plus d'adhésivité ». .

Mais cette information erronée était une vieille blague de Reddit. Cette suggestion surprenante n’était même pas une invention du modèle d’IA de Google. Le chatbot l'a simplement plagié à partir d'un commentaire ironique qu'un utilisateur de Reddit nommé Fucksmith a fait il y a 11 ans. Pourquoi l'IA de Google a-t-elle considéré ce commentaire comme légitime ? Impossible de le savoir.

Google utilise les données de Reddit pour son IA. Et cela aussi officiellement grâce à l’accord conclu il y a quelques semaines par les deux sociétés. Cela permet aux modèles d'IA de Google d'être entraînés avec tous les commentaires sur cette plateforme, et bien que beaucoup soient utiles, d'autres ne sont que des blagues et des ironies.

Perroquets stochastiques. L’IA ne comprend ni ce qu’elle lit ni ce qu’elle écrit. Une étude de 2021 a déjà montré clairement à quel point ces types de modèles d’IA générative sont comme des perroquets stochastiques : ils peuvent être convaincants pour générer du texte, mais on ne comprend vraiment pas ce qu’ils font.

Dangereusement faux. Ici, les probabilités règnent en maître, et si le modèle considère que coller le fromage sur la pizza est pertinent – en raison de la manière dont il est programmé – il le recommandera sans savoir si c'est ou non une méthode appropriée pour obtenir cet effet. Ici, l'erreur est encore plus agréable, mais le problème est qu'elle peut se produire dans des scénarios beaucoup plus sensibles.

Un autre désastre de l'IA de Google. Les erreurs des modèles d’IA de Google deviennent tristement célèbres. Tout a commencé avec Bard et son erreur sur une question concernant le télescope spatial James Webb. Il y a à peine trois mois, des problèmes ont été rencontrés avec leur moteur de génération d'images qui était excessivement inclusif, et maintenant ils commettent une fois de plus une erreur innocente mais majeure avec cette méthode de cuisson de la pizza.

Juste au cas où, ne fais pas confiance. Bien que Google ait commis une erreur, tous les chatbots commettent des erreurs dans toutes sortes de domaines. Même dans des domaines comme les mathématiques, un domaine où nous comptons sur les ordinateurs, ChatGPT commettre erreurs groupées, mais nous insistons, lui et d’autres le font, aussi bien en mathématiques que dans bien d’autres domaines dans lesquels il invente des données. La conclusion reste la même : au cas où, ne vous fiez pas à tout ce qu'il vous dit et vérifiez ces réponses.

Oh, et autre chose. Vive la pizza à l’ananas.

À Simseo | ChatGPT rédige des études médicales et économiques. Nous le savons parce qu'il utilise des mots étranges